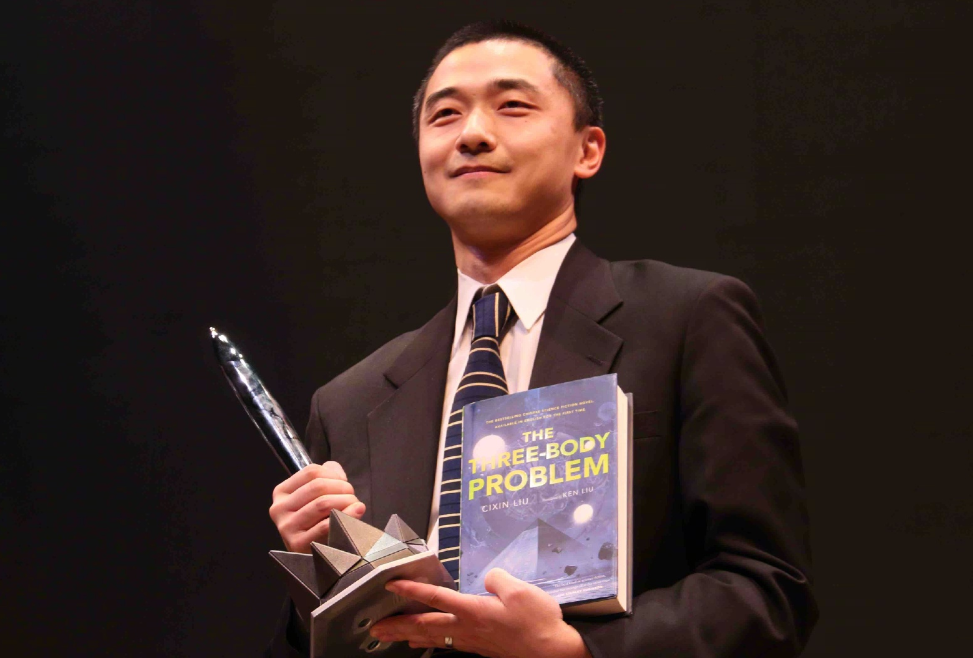

值得注意的是,知名科幻作家刘宇昆(热剧《万神殿》背后的小说作者、《三体》英文版译者)也参与了这一项目。

值得注意的是,知名科幻作家刘宇昆(热剧《万神殿》背后的小说作者、《三体》英文版译者)也参与了这一项目。 图片来源:新浪微博

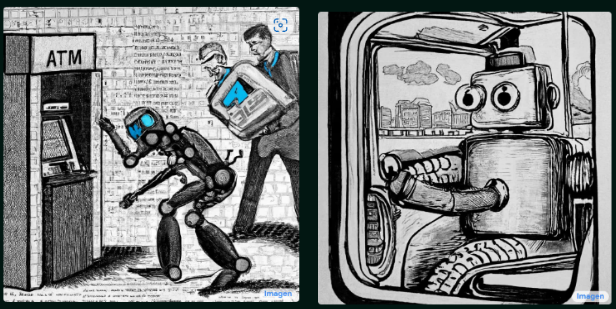

图片来源:新浪微博 图片来源:Emily Reif via Imagen

图片来源:Emily Reif via Imagen

| 一个蓝色的气球插在红杉树的树枝上镜头从挂着蓝色气球的树上移到动物园门口镜头快速移动到动物园内第一人称视角:在一个美丽的花园内飞行长颈鹿的头从旁边冒出来长颈鹿走向一棵树 | 放大长颈鹿的嘴长颈鹿靠近树枝,拿起一个蓝色的气球一个带白线的蓝色气球向长颈鹿的头部飞去长颈鹿在附近咀嚼蓝气球镜头随着单个蓝气球的飞走而向上倾斜 |

图片来源:DreamFusion: Text-to-3D using 2D Diffusion (dreamfusion3d.github.io)

图片来源:DreamFusion: Text-to-3D using 2D Diffusion (dreamfusion3d.github.io)

*博客内容为网友个人发布,仅代表博主个人观点,如有侵权请联系工作人员删除。